Не упустите интересные новости

Грядущая модель ИИ от OpenAI, по словам источников издания The Information, покажет менее ощутимый прирост производительности по сравнению с предыдущими версиями.

Согласно опубликованным данным, модель Orion достигла уровня GPT-4 после прохождения лишь 20% обучения. Это свидетельствует о том, что GPT-5 не сможет так существенно превзойти GPT-4, как это произошло с GPT-3 при переходе к GPT-4.

“Orion не демонстрирует существенных преимуществ в выполнении определенных задач. Она хорошо справляется с языковыми задачами, но не превосходит предыдущие модели в программировании”, – отмечают сотрудники стартапа.

Обычно наибольшие улучшения в нейросетях наблюдаются на начальных этапах обучения. Далее прогресс постепенно замедляется. По словам источников The Information, остаток в 80% времени обучения вряд ли принесет ощутимый скачок в производительности.

Недавние результаты OpenAI, не отличающиеся оптимизмом, освещают более глобальную проблему: нехватку качественных данных для обучения.

В исследовании, опубликованном в июне, эксперты заявили, что компании из сферы ИИ исчерпают все доступные текстовые материалы в период между 2026 и 2032 годами. Это может стать переломным моментом для традиционных подходов к развитию искусственного интеллекта.

“Наши результаты показывают, что современные тенденции развития LLM невозможно поддерживать только через масштабирование данных,” – отмечают авторы исследования.

В работе отмечается необходимость искать альтернативные подходы для совершенствования нейросетей, в частности создание синтетических данных или использование закрытой информации.

Издание The Information обратило внимание на то, что нынешняя стратегия обучения LLM на открытых текстовых данных с веб-сайтов, книг и других источников достигла точки уменьшения эффективности, ведь “разработчики выжали из этого формата все, что могли”.

OpenAI и другие компании существенно меняют подходы к созданию искусственного интеллекта.

“На фоне замедления темпов улучшения GPT, похоже, что индустрия теперь больше сосредотачивается на совершенствовании моделей после их первичного обучения, а не на масштабировании во время учебного процесса. Такой подход может способствовать появлению новых правил масштабирования,” – сообщает издание The Information.

Чтобы достичь постоянного развития своих моделей, OpenAI разделяет процесс на два основных направления:

В ходе АМА-сессии Кевин Вайль, директор по продуктам OpenAI, отметил, что в будущем планируется интеграция этих двух подходов, что позволит объединить их преимущества.

Создание искусственных данных для решения проблемы их нехватки может серьезно повлиять на надежность информации. Эту проблему осветили исследователи из нескольких университетов Великобритании.

По их мнению, такой подход может полностью оторвать искусственный интеллект от реальности и привести к так называемому “коллапсу модели”. Главная проблема – это использование недостоверных данных для создания обучающих наборов следующих поколений ИИ.

Чтобы избежать этого, OpenAI разрабатывает фильтрующие механизмы, которые помогают сохранять качество информации. Эти механизмы интегрируют различные методы проверки для отделения качественного контента от потенциально проблемного.

Еще одним действенным решением является оптимизация после обучения. Исследователи работают над методами улучшения производительности ИИ после первоначальной настройки, не ограничиваясь лишь расширением набора данных.

Ранее СМИ сообщали, что OpenAI планирует запустить новую передовую модель под кодовым названием Orion к декабрю. Однако позже генеральный директор компании Сэм Альтман опроверг эту информацию.

Некоторые ученые, исследователи и инвесторы поделились с Reutersмнением, что методы, на которых базируется новая AI-модель o1, могут “изменить ход гонки вооружений” в сфере искусственного интеллекта.

В сентябре OpenAI представила o1 – большую языковую модель, которую обучали с помощью подкрепления для выполнения сложных логических задач. В компании утверждают, что эта нейросеть “умеет думать”, формируя детализированный внутренний процесс анализа во время решения вопросов.

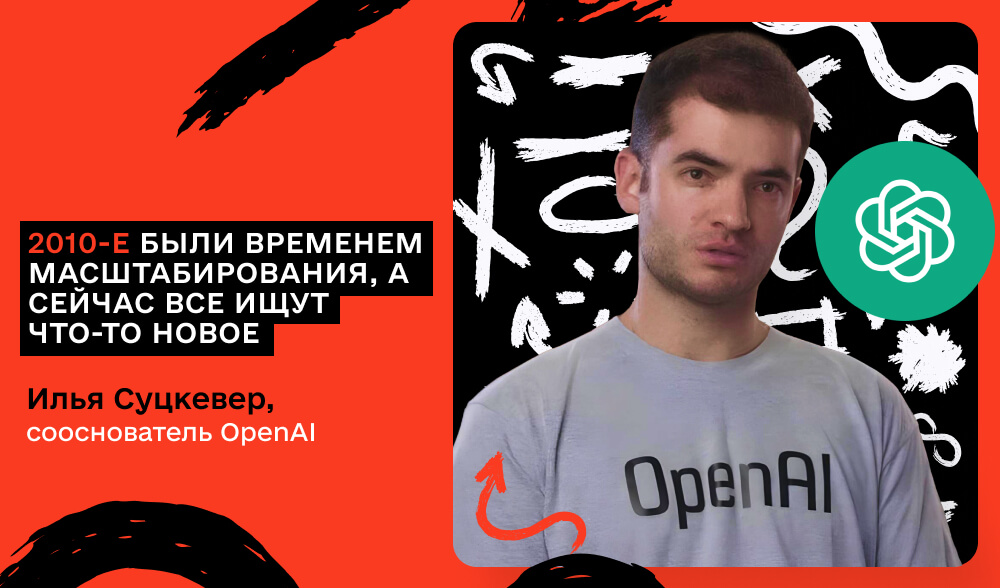

Сооснователь AI-стартапов Safe Superintelligence (SSI) и OpenAI Илья Суцкевер отметил, что результаты обучения на больших массивах немаркированных данных “достигли своего пика”.

“2010-е были временем масштабирования, а сейчас мы снова оказались в эпохе чудес и открытий. Все ищут что-то новое”,– сказал он.

Суцкевер воздержался от разглашения деталей работы своей новой компании SSI, лишь намекнув на альтернативный подход к масштабированию предварительного обучения.

Источники Reuters заметили, что исследователи крупных AI-лабораторий сталкиваются с задержками и неудовлетворительными результатами, пытаясь создать языковую модель, которая превзошла бы GPT-4 от OpenAI, выпущенную почти два года назад.

Они экспериментируют с улучшением работы нейросетей во время так называемой “фазы вывода”. Например, вместо предоставления одного ответа, AI сначала генерирует несколько вариантов и выбирает лучший.

Напомним, в октябре появилась информацияо том, что OpenAI работает над созданием собственного AI-чипа. Расскажем больше об этом в следующих статьях, не пропустите.